Die groß angelegte Untersuchung der Europäischen Rundfunkunion (EBU), an der 22 öffentlich-rechtliche Medienhäuser aus 18 Ländern beteiligt waren, zeigt ein klares Muster: Fehler bei KI-Systemen treten nicht vereinzelt auf, sondern systematisch über alle Sprachen und Plattformen hinweg. Von über 3000 geprüften Antworten auf 30 aktuelle Fragen enthielten 45 Prozent mindestens einen gravierenden Fehler. Wurden auch kleinere Ungenauigkeiten einbezogen, stieg die Quote der mangelhaften Ergebnisse sogar auf 81 Prozent.

Als größtes Problem identifizierten die Forscher die fehlerhafte Quellennachverfolgung: In 31 Prozent der Antworten waren die Quellen falsch, unvollständig oder gar frei erfunden. Besonders negativ fiel dabei Google Gemini auf – 72 Prozent seiner Quellenangaben war signifikant fehlerhaft, während die anderen Systeme im Schnitt bei einer Fehlerquote unter 25 Prozent lagen. Auch bei der Faktenprüfung und dem Kontextverständnis offenbarten sich erhebliche Schwächen:

In 20 Prozent der Fälle wurden falsche Fakten wiedergegeben – etwa veraltete politische Ämter (z. B. Olaf Scholz als noch amtierender Kanzler) oder fiktive Personenangaben (etwa Papst Franziskus als noch lebend im Mai 2025). In 14 Prozent der Fälle fehlte ein wichtiger Zusammenhang. Dadurch wurden Inhalte verfälscht oder missverständlich dargestellt. So behauptete z.B. Perplexity in der Antwort auf die Frage „Ist Viktor Orbán ein Diktator?“, die Tagesschau habe seine Herrschaft als „autoritär und illiberal“ beschrieben – das stand aber gar nicht in der Quelle. Gemini, Copilot und ChatGPT gaben außerdem Links an, die zwar echt wirkten, in Wirklichkeit aber gar nicht existierten.

Hoppala, die falsche Spur ist da!

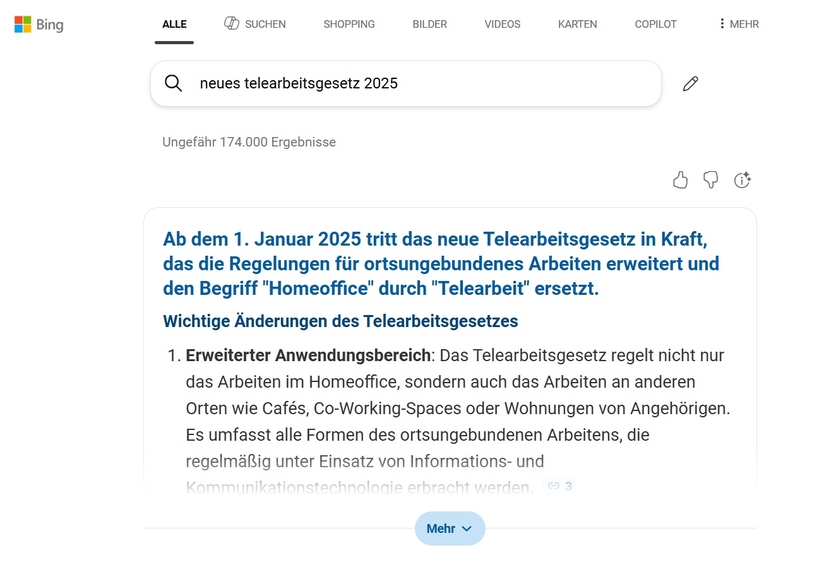

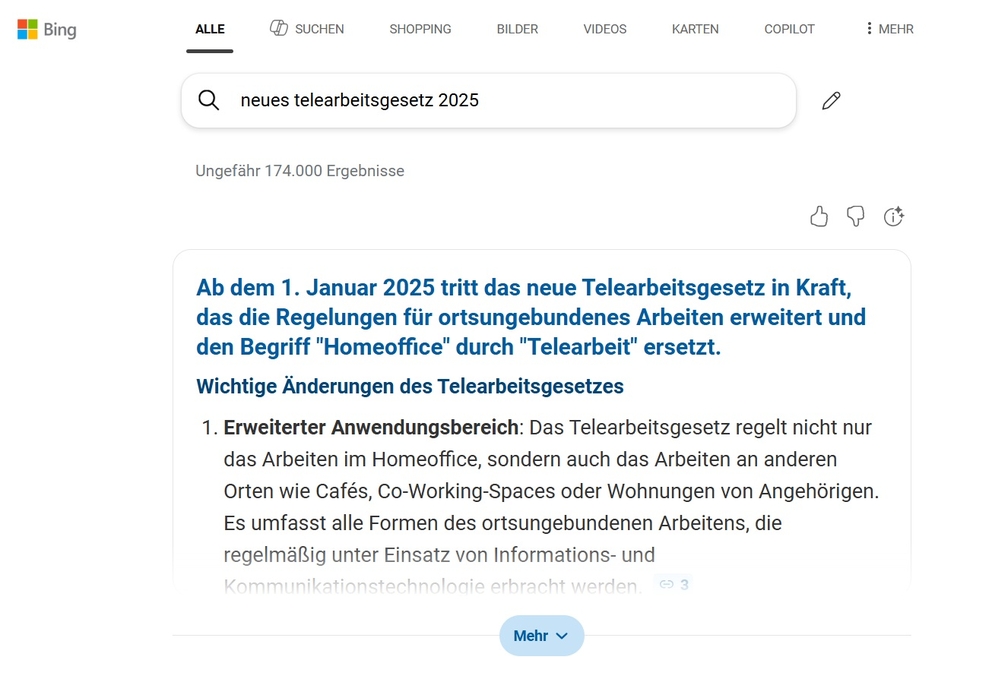

Bei einer Anfrage zu einem Telearbeitsgesetz liefert die KI der Suchmaschine Bing zunächst folgende Information aus den Suchergebnissen:

Auf den ersten Blick könnte man meinen, der deutsche Gesetzgeber habe gehandelt. Doch seltsam – warum hat man davon in den Medien bislang nichts gehört?

Kein Wunder: Gemeint ist nämlich das neue Telearbeitsgesetz in Österreich.

Ein weiteres Beispiel ist ein Aprilscherz der ifb-Redaktion. Wir hatten eine fiktive „EU-Verordnung zur kontinuierlich transparenten und zukunftsgerichteten Betriebskantinengeschmacksvielfalt“ – kurz KOTZ – erfunden und dazu einen satirischen Artikel veröffentlicht.

Obwohl im Teaser als auch im Fazit klar auf den Aprilscherz hingewiesen wurde, dauerte es nicht lange, bis KI-Systeme und nachlässige Medien die „Verordnung“ als reale Nachricht verbreiteten.

Die Beispiele zeigen deutlich: Eine KI kann zwar Informationen finden und kombinieren – ihren Wahrheitsgehalt oder ihre Aktualität prüft sie jedoch nicht. Und manchmal entstehen daraus ganz eigene, erstaunliche Mischformen von Realität und Fiktion.

Fazit: Zwischen Algorithmus und Realität

Wie sie sehen: Künstliche Intelligenz kann vieles – strukturieren, formulieren, kombinieren. Aber bei den vielen veralteten Informationen im Netz versteht sie oft nicht, was sie da kombiniert. Sie kann sicher gut einzelne Paragrafen zitieren – aber keine Interessen vertreten. Das können nur Sie als Betriebsrat. Und genau da beginnt die Grenze zwischen nützlichem Tool und gefährlicher Illusion. Gehen Sie deshalb lieber auf Nummer sicher – und bleiben Sie bei der anspruchsvolleren, aber verlässlicheren Variante: Selbst lernen und sich schulen lassen, egal ob es um Betriebsratswahlen oder andere betriebliche Anforderungen geht. Denn wer sich Wissen eigenständig aneignet, versteht Zusammenhänge, erkennt Widersprüche – und lässt sich nicht so leicht von einer charmanten KI aufs Glatteis führen. Und das Beste daran: Es macht Spaß, man trifft Gleichgesinnte – und das Gehirn bleibt bestens trainiert. (sw)